در این آموزش به نحوه ساخت فایل robots.txt برای وردپرس میپردازیم تا بدانید چطور فایل robots را در هاست ایجاد کنید و نمونه بهترین فایل robots txt را ارائه دادیم تا درخصوص بهینه سازی robots txt سایت خود اقدام کنید. در ادامه کامل بررسی میکنیم که Robots txt کجاست و چطور آن را مدیریت کنیم.

آموزش ساخت فایل robots.txt برای وردپرس و بهینه سازی robots.txt در وردپرس میتونه به شما کمک کنه تا دسترسی لازم برای موتورهای جستجو را برای دایرکتوری یا همان پوشه های موجود در هاستتان تعیین کنید تا با اینکار اجازه اینکه موتورهای جستجو بتوانند تا چه آدرس هایی را مورد بررسی قرار بدهند و چه آدرس هایی را نمیتوانند بررسی کرده و در خودشان ایندکس کنند را تعیین کنید.

فایل Robot txt چیست؟

مهم ترین خاصیتی که با ساخت robots.txt وردپرس میتوانید به دست بیاورید اینه که در واقع یک حریم خصوصی برای هاست خودتان تعیین میکنید تا به این وسیله موتورهای جستجو نتوانند تا پوشه ای از هاست شما که شامل تصاویر خصوصی و فایل هایی که برایتان جنبه خصوصی را دارند بررسی کنند.

و اما برای ربات های جستجوگر هم این امر باعث میشود تا سایت هایی که دارای فایل robots.txt دارند را بهتر درک کرده و تو جاهایی که به آنها دسترسی داده نشده کمتر سرک بکشند. به همین خاطره که گاهی اوقات میبینیم که وقتی دنبال یک نتیجه از سایتی هستیم با پیغام به علت robots txt این سایت توضیحی برای این نتیجه در دسترس نیست مواجه میشویم.

پس تا اینجا متوجه شدید که فایل robots.txt وردپرس این وظیفه را داره تا دسترسی ربات های موتورهای جستجوگر همچون گوگل را به محتویات سایت شما کنترل کنه و به مسیرهایی از هاست که نمیخواهند تا دسترسی داشته باشند دسترسی نداشته باشند. ربات های جستجوگر به محض ورود به سایتی ابتدا این فایل را بررسی میکنند تا ببینند به چه دایرکتوری هایی دسترسی دارند و بعد از اینکه وظیفه و مسیرشان مشخص شد شروع به بررسی کامل یک سایت میکنند.

ساخت robots.txt وردپرس و بهینه سازی

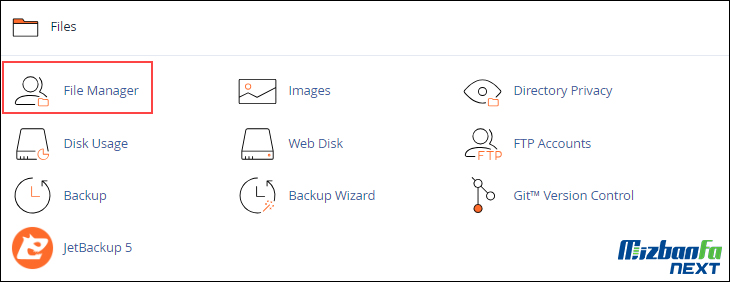

برای ساخت فایل robots.txt وردپرس ابتدا وارد هاست خودتان شوید و بعد از ورود برروی File Manager کلیک کنید تا به فایل منیجر هاست هدایت شده و بتوانید فایل های موجود در هاست را کنترل کنید.

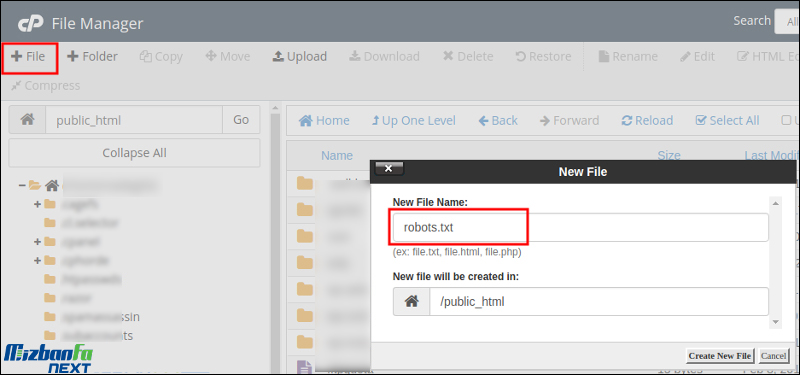

بعد از کلیک روی این دکمه به مسیر /public_html/ مراجعه کنید تا به مسیری که وردپرس در اون نصب هست برسید. اگر وردپرس روی دامنه اصلی شما نصب شده کافی است توی همین مسیر باشید اما اگر در پوشه جدایی آن را نصب کردید باید وارد همون پوشه از هاست خودتون شوید.

حال که به مسیر درست رسیدید با استفاده از برنامه notepad یا هر نرم افزار ویرایشگر متن که دارید یک فایل با نام robots.txt و همین فرمت بسازید و با کلیک روی دکمه آپلود در فایل منیجر هاست اونو به این مسیر اضافه کنید. یا اینکه با کلیک روی دکمه FILE+ کلیک کنید تا پنجرهای مشابه تصویر زیر براتون باز بشه و بعدش نام فایل را در فیلد New File Name با نام robots.txt وارد کنید و در نهایت روی دکمه Create New File کلیک کنید تا فایل شما ساخته شود.

حال که فایل را ایجاد کردید بر اساس توضیحاتی که در ادامه میدهیم میتوانید تا با دستورات و قوانینی که این فایل دارد دسترسی برای موتورهای جستجو توسط این فایل را به پوشه های مختلف از هاست خودتان کنترل کنید.

دقت کنید که فایل robots.txt وردپرس همونطور که گفتم شامل یک فایل متنی با فرمت txt. هستش که در اون نمیتوانید از دستوراتی که در زبان هایی مثل HTML و CSS استفاده کنید. بلکه باید هر دستور را در یک سطر وارد کنید و اینکه در این فایل شما صرفا محدود به چند دستور ساده هستید که در ادامه به معرفی آنها خواهم پرداخت.

ساخت فایل robots برای وردپرس

به طور کلی فایل robots.txt از دو دستور و قانون پیروی میکند که عبارتند از:

- User-agent

- Disallow

Disallow: این دستور هم نشون دهنده این است که ربات اجازه ورود به چه مسیرهایی در هاست شما را نخواهد داشت.

بنابراین شما با استفاده از این دو دستور میتونید تا قوانین مختلفی را برای هریک از رباتهای موتورهای جستجو و سایت ها تعیین کنید تا عدم دسترسی به دایرکتوری های گوناگون در هاست خودتان را تعیین کنید. اما برای استفاده از هر ربات ابتدا لازمه تا با لیست ربات هایی که تا به امروز ساخته شدند آشنا شوید. برای این کار میتوانید با کلیک روی این لینک، لیست کلیه ربات های اینترنتی که تا به امروز برای خزش سایت ها ساخته شدند دسترسی داشته باشید.

User-agent: این دستور نشان دهنده این است که میتوانید تعیین کنید چه نوع رباتی قادر به دسترسی به دایرکتوری های تعیین شده در هاست شما خواهد بود. منظور از نوع ربات این است که ربات کدام سایت و یا موتور جستجو میتواند تا از این دستورات پیروی کند.

با استفاده از این دستور میتوانید یک قانون را برای همه ربات ها و یا یک ربات خاص تعیین کنید. به عنوان مثال اگر شما درون هاستتان پوشه ای با نام mizbanfa دارید و میخواین که دسترسی به این پوشه برای کلیه رباتها فراهم نباشه کافیه تا در سطر اول User-agent را وارد کرده و مقدار اون را روی کاراکتر * تعیین کنید و بعدش با دستور /disallow: /mizbanfa دسترسی به این پوشه را برای کل رباتها غیرفعال کنید. در این صورت هر رباتی که وارد سایت شما بشه از این قانون تبعیت کرده و وارد پوشه mizbanfa در هاست شما نخواهد شد. پس به صورت کلی ساختاری که برای این حالت تعیین میکنید باید دستور زیر را در فایل robots.txt وارد کنید. برای این کار کافیه تا روی فایل robots.txt که در هاست شما قرار داره راست کلیک کرده و گزینه Edit را انتخاب کنید.

User-agent: *

Disallow: /mizbanfa/حالا برای اینکه بدانید کدام مسیرها را در این فایل درج کنید به بخش بعدی بروید و ساختار را با دقت کامل کنید.

سطح دسترسی به ربات خاص با فایل robots.txt وردپرس

همه ما ممکن است تا گاهی به این نیاز پیدا کنیم تا تصویری را در هاست خودمان آپلود کنیم و در اختیار دیگران قرار بدهیم که نمیخواهیم این تصویر در دسترس عموم کاربران قرار بگیرد و به عبارت دیگر دیگران وارد حریم خصوصی ما نشوند، بنابراین برای اینکه این تصویر توسط موتورهای جستجو ایندکس نشود باید از طریق فایل robots.txt اقدام کنیم. خب حالا شاید بپرسید که برای اینکار باید از کجا شروع کنیم.

خب همانطور که در سایت robotstxt.org دیدید ما یک لیست بزرگ از ربات های مختلف را داریم. گوگل هم بر همین اساس دارای ربات های گوناگونی است که هر کدام از این ربات ها وظیفه بررسی و خزش محتوای خاصی از سایت ها را دارند. به عنوان مثال معروف ترین ربات گوگل که با نام Googlebot شناخته شده وظیفه بررسی و ایندکس صفحات را داره که بعد از ثبت سایت در گوگل کار خودش را برای سایت ما آغاز میکند. یا ربات Googlebot-image وظیفه بررسی و ایندکس تصاویر را دارد که در این مثال ما باید از این بات برای غیرفعال کردن دسترسی این بات به تصویر خودمان استفاده کنیم.

بنابراین مشابه مثال قبل ابتدا با استفاده از دستور User-agent ربات خودمان را تعیین میکنیم. در اینجا چون شامل یک ربات است دیگر نباید از ستاره استفاده کرد و باید نام ربات را بنویسیم، سپس در خط بعدی هم با استفاده از دستور Disallow دسترسی به پوشه ای که تصویر در آن قرار دارد را لغو میکنیم. به صورت کلی دستور ما مشابه زیر خواهد بود.

user-agent: Googlebot-image

disallow: /mizbanfa/در اینجا mizbanfa هم همhن پوشه ای است که تصویر در این مسیر از هاست قرار دارد. بنابراین بعد از ذخیره کردن فایل دیگر ربات گوگل همچین آدرسی را مورد بررسی قرار نداده و تصویر شما توسط گوگل ایندکس نخواهد شد.

لیست کلیه دستورات قابل استفاده در robots.txt

تا اینجای کار دانستید که برای تعیین دسترسی برای هر ربات کافی است تا با دستور user-agent آن را تعیین کنید. اگر ربات خاصی مد نظرتان است نام ربات را وارد کنید اما اگر همه ربات ها مدنظر شماست کافی است تا مقدار این دستور را روی * قرار بدهید. برای هر قانونی که تعیین میکنید باید از user-agent جدا استفاده کنید و سپس مسیری که میخواهید تا دسترسی به آن را لغو کنید را بر اساس زیر وارد کنید.

اگر قصد دارید تا دسترسی به کل سایت را غیرفعال کنید میتوانید از مشابه دستور زیر برای Disallow استفاده کنید.

Disallow: /برای عدم دسترسی به یک پوشه خاص کافیه تا نام آن پوشه و یا زیر پوشه های آن را وارد کنید.

Disallow: /blog/

Disallow: /blog/file/برای محدود کردن به دسترسی به یک فایل میتوانید تا به شکل زیر عمل کنید.

Disallow: /images/dogs.pdf

Disallow: /files/project.pdfبرای محدود کردن فایل هایی به فرمت خاص در کل سایت میتوانید تا از دستور زیر استفاده کنید.

Disallow: /*.gif$

Disallow: /*.pdf$

Disallow: /*.docs$ثبت فایل robots.txt در گوگل

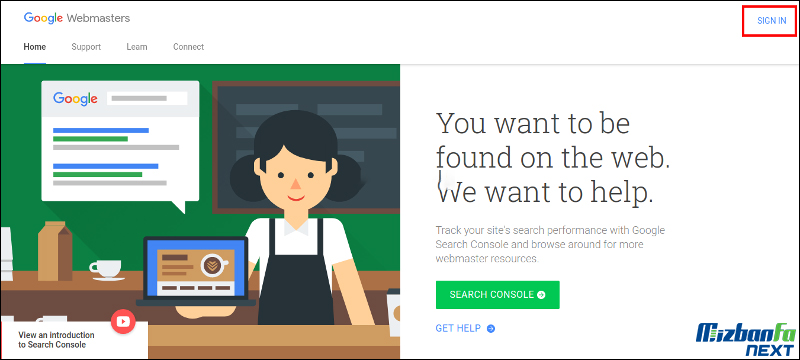

برای ثبت این فایل ابتدا باید وارد آدرس https://www.google.com/webmasters شوید و سپس روی دکمه Sign In کلیک کنید تا وارد کنسول جستجوی گوگل شده و سپس سایت خودتان را در گوگل ثبت کردید انتخاب کنید.

بعد از اینکه سایت خودتان را انتخاب کردید مشابه تصویر زیر به مسیر Crawl> robots.txt Tester مراجعه کنید.

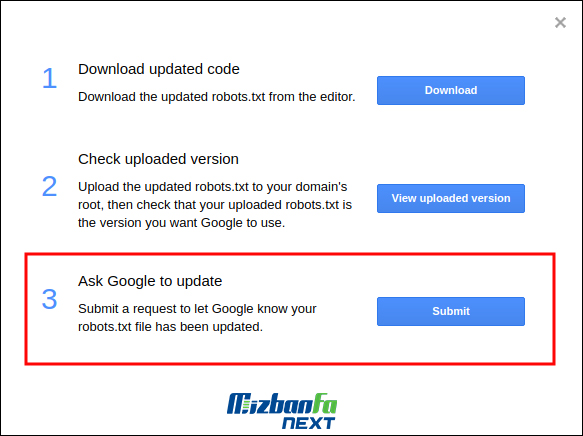

مشابه تصویر در فیلد مشخص شده عبارت robots.txt را وارد کنید و روی دکمه TEST کلیک کنید تا با پیغام سبز رنگ Allowed مواجه بشید. اگر درست بود حالا محتویات فایل robots.txt را وارد ویرایشگری که میبینید بکنید و روی دکمه Submit کلیک کنید تا پنجره زیر برایتان باز شود.

خب در اینجا ما چون از قبل فایل را در هاست اپلود کردیم با کلیک روی دکمه Submit گزینه سوم را انتخاب کنید.

بهینه سازی فایل robots.txt وردپرس

حال که با ساختار فایل robots.txt وردپرس آشنا شدید در ادامه به معرفی راه هایی برای بهینه سازی robots.txt میپردازم تا با استفاده از این راه ها سئو وردپرس خودتان را بهبود دهید.

یکی از باورهای غلط که در بین وبمستران مشاهده میشود این است که با استفاده از این فایل باید صفحات بی کیفیت مثل آرشیو و دسته بندی را از دسترسی به ربات های جستجوگر غیرفعال کنند. باید گفت که در رابطه با نه تنها وردپرس بلکه هیچ CMS دیگه ای این گفته درست نیست. چرا که آدرس هایی مثل آرشیو، برچسب، دسته بندی و… در وردپرس در حکم یک پوشه یا دایرکتوری نیستند که با استفاده از این روش بتوانید دسترسی به آنها را غیرفعال کنید. بلکه این آدرها از طریق دیتابیس تعیین شده اند و عملا پوشه ای با نام category یا tag در هاست شما وجود ندارد که با استفاده از این روش بخواهید دسترسی را محدود کنید.

اگر که شما قصد دارید تا صفحات خاصی را از دسترسی ربات های جستجوگر غیرفعال کنید کافی است تا با استفاده از افزونه هایی نظیر سئو وردپرس این کار را انجام بدهید که قابلیت Noindex در آنها قرار دارد که در مقاله ای جامع به معرفی این کارها خواهم پرداخت.

چند نکته درباره فایل robots.txt

نکته اول: صفحاتی مثل صفحه ورود وردپرس و صفحه پیشخوان وردپرس که به ترتیب در آدرس های wp-login.php و wp-admin در دسترس هستند به صورت پیش فرض در حالت Noindex هستند، بنابراین نیازی نیست تا با استفاده از فایل robots.txt دسترسی به این دو صفحه را محدود کنید.

نکته دوم: نقشه سایت یا Sitemap خود را در این فایل مشابه نمونه زیر وارد کنید تا وقتی ربات های جستجوگر فایل robots.txt را بررسی میکنند نقشه سایت را مشاهده کرده و قبل از هر صفحه از سایت این صفحه را مورد بررسی قرار دهند تا سرعت ایندکس صفحات شما بیشتر شود. برای این کار کافی است تا دستور زیر را در خط انتهایی این فایل وارد کنید.

Sitemap: http://mizbanfa.net/post-sitemap.xml

Sitemap: http://mizbanfa.net/page-sitemap.xmlنکته سوم: فایل readme.html را با استفاده از فایل robots.txt در حالت محدود قرار دهید. چرا که برخی افراد سعی میکنند تا با استفاده از این فایل اطلاعاتی مثل نسخه مورد استفاده از وردپرس و… را که معمولا توسط ربات این کارها انجام میگیره به دست آورده و با استفاده از آن شروع به کارهای مخرب روی سایت شما بکنند. هرچند که راه های بسیار زیادی برای دانستن نسخه مورد استفاده وجود دارد اما اگر سایر راه ها را بسته باشید و تنها این راه بر سر راه فرد قرار گرفته باشد با این روش هم دیگر قادر نخواهد بود تا نسخه وردپرس مورد استفاده شما را بداند و برای این کار کافی است تا دستور زیر را برای کلیه ربات ها تعیین کنید.

Disallow: /readme.htmlنکته چهارم: دسترسی به دایرکتوری افزونه های وردپرس را محدود کنید. با استفاده از این کار دایرکتوری که افزونه های وردپرس درآن قرار دارند ایمن شده و مشابه همان فایل readme.html برایش اتفاق افتاده و میشود امنیت سایت خودتان را افزایش بدهید. برای این کار کافیه تا دستور زیر را به فایل robots.txt اضافه کنید تا دسترسی به پوشه افزونه های وردپرس از ربات ها مصون بماند.

Disallow: /wp-content/plugins/نمونه فایل robots.txt مناسب

احتمالا تا اینجای آموزش این سوال برای شما هم پیش آمده که یک فایل مناسب و نمونه فایل robots.txt که باید ازش استفاده کنیم به چه صورتی میتواند باشد؟ در پاسخ به این سوال میتوانید از نمونه زیر استفاده کنید و بعدش با شخصی سازی آن و اعمال تغییرات بر اساس همین آموزش دسترسی به پوشه ها مختلف در هاست خودتان را کنترل کنید.

User-Agent: *

Disallow: /wp-content/plugins/

Disallow: /readme.html

Sitemap: http://mizbanfa.net/post-sitemap.xml

Sitemap: http://mizbanfa.net/page-sitemap.xmlRobots txt کجاست؟

فایل robots.txt در مسیر اصلی وبسایت قرار گرفته است مثلا اگر وبسایت وردپرسی داریدف در جایی که وردپرس نصب شده فایل robots.txt نیز قرار میگیرد. در هاست سی پنل یا دایرکت ادمین با مراجعه به بخش file manaager و سپس قسمت public_html می توانید این فایل را ایجاد یا مدیریت کنید.

سوالات متداول آموزش ساخت فایل robots.txt برای وردپرس و بهینه سازی آن

-

فایل robots.txt چیست؟

این فایل درواقع برای انواع ربات های موتور های جستجو ساخته می شود تا امکان بررسی و دسترسی به فایل های هاست را داشته باشند.

-

هدف از بهینه سازی فایل robots.txt چیست؟

این بهینه سازی برای جلوگیری از خزش و ورود ربات های موتور های جستجو به فایل هایی در هاست است که نیازی به دسترسی عمومی ندارد.

-

معنی User-agent و Disallow چیست؟

User-agent * یعنی تمامی ربات ها و Disallow تعیین کننده مسیری است که ربات ها به آن دسترسی نخواهند داشت.

-

ایندکس برای محدود کردن یکسری از صفحات برای ربات های گوگل است؟

ایندکس به معنای فهرست شدن است و زمانی که می گوییم یک مطلب در گوگل ایندکس شده است یعنی آن مطلب در نتایج گوگل نمایش داده می شود.

نتیجه گیری

آموزش ساخت فایل robots.txt در وردپرس و بهینه سازی این فایل یکی از راه هایی است که میتواند دسترسی موتورهای جستجو به دایرکتوری و یا پوشه ای در هاست را تعیین کند. ما در این مقاله ساخت فایل robots.txt و بهینه سازی این فایل را یه صورت کامل آموزش داده ایم. نمونه فایل robots.txt مناسب به شما ارائه دادیم و گفتیم Robots txt کجاست. ساخت robots.txt وردپرس و بهینه سازی robots.txt بسیار مهم است و باید توجه ویژه ای به آن داشت.

![بهترین افزونه سئو وردپرس [8 افزونه سئو تا بهینه سازی سایت]](https://mizbanfa.net/next/wp-content/uploads/2025/11/best-seo-plugins-300x169.jpg)