آموزش ساخت فایل robots.txt برای وردپرس و بهینه سازی آن

ساخت robots.txt وردپرس و بهینه سازی robots txt میتونه به شما کمک کنه تا دسترسی لازم برای موتورهای جستجو را برای دایرکتوری یا همون پوشههای موجود در هاستتون تعیین کنید تا با اینکار اجازه اینکه موتورهای جستجو میتونند تا چه آدرسهایی را مورد بررسی قرار بدن و چه آدرسهایی رو نمیتونن بررسی کرده و در خودشون ایندکس کنند را تعیین کنید. مهمترین خاصیتی که با ساخت robots.txt وردپرس میتونید به دست بیارید اینه که در واقع یک حریم خصوصی برای هاست خودتون تعیین میکنید تا به این وسیله موتورهای جستجو نتونن تا پوشهای از هاست شما که شامل تصاویر خصوصی و فایلهایی که براتون جنبه خصوصی را دارند بررسی کنند. و اما برای ربات های جستجوگر هم این امر باعث میشه تا سایتهایی که دارای فایل robots.txt دارند را بهتر درک کرده و تو جاهایی که بهشون دسترسی داده نشده کمتر سرک بکشند. به همین خاطره که گاهی اوقات میبینیم که وقتی دنبال یک نتیجه از سایتی هستیم با پیغام به علت robots txt این سایت توضیحی برای این نتیجه در دسترس نیست مواجه میشیم.

پس تا اینجا متوجه شدید که فایل robots.txt وردپرس این وظیفه را داره تا دسترسی رباتهای موتورهای جستجوگر همچون گوگل را به محتویات سایت شما کنترل کنه و به مسیرهایی از هاست که نمیخواین تا دسترسی داشته باشند دسترسی نداشته باشند. رباتهای جستجوگر به محض ورود به سایتی ابتدا این فایل را بررسی میکنند تا ببینند به چه دایرکتوریهایی دسترسی دارند و بعد از اینکه وظیفه و مسیرشون مشخص شد شروع به بررسی کامل یک سایت میکنند.

ساخت robots.txt وردپرس و بهینه سازی robots.txt

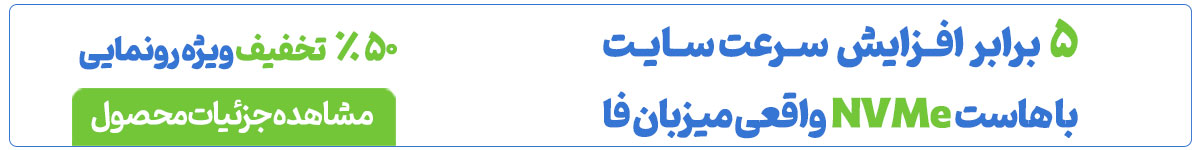

برای ساخت فایل robots.txt وردپرس ابتدا وارد هاست خودتون بشید و بعد از ورود روی File Manager کلیک کنید تا به فایل منیجر هاست هدایت شده و بتونید فایلهای موجود در هاست را کنترل کنید.

بعد از کلیک روی این دکمه به مسیر /public_html/ مراجعه کنید تا به مسیری که وردپرس در اون نصب هست برسید. اگر وردپرس روی دامنه اصلی شما نصب شده کافیه توی همین مسیر باشید اما اگر در پوشه جدایی اونو نصب کردید باید وارد همون پوشه از هاست خودتون بشید. حالا که به مسیر درست رسیدید با استفاده از برنامه notepad یا هر نرمافزار ویرایشگر متن که دارید یک فایل با نام robots.txt و همین فرمت بسازید و با کلیک روی دکمه آپلود در فایل منیجر هاست اونو به این مسیر اضافه کنید. یا اینکه با کلیک روی دکمه FILE+ کلیک کنید تا پنجرهای مشابه تصویر زیر براتون باز بشه و بعدش نام فایل را در فیلد New File Name با نام robots.txt وارد کنید و در نهایت روی دکمه Create New File کلیک کنید تا فایل شما ساخته شود.

حالا که فایل را ایجاد کردید بر اساس توضیحاتی که در ادامه میدم میتونید تا با دستورات و قوانینی که این فایل داره دسترسی برای موتورهای جستجو توسط این فایل را به پوشههای مختلف از هاست خودتون کنترل کنید.

به طور کلی فایل robots.txt از دو دستور و قانون پیروی میکنه که عبارتند از:

- User-agent: این دستور نشان دهنده اینه که میتونید تعیین کنید چه نوع رباتی قادر به دسترسی به دایرکتوریهای تعیین شده در هاست شما خواهد بود. منظور از نوع ربات اینه که ربات کدوم سایت و یا موتور جستجو میتونه تا از این دستورات پیروی کنه

- Disallow: این دستور هم نشون دهنده اینه که ربات اجازه ورود به چه مسیرهایی در هاست شما را نخواهد داشت.

بنابراین شما با استفاده از این دو دستور میتونید تا قوانین مختلفی را برای هریک از رباتهای موتورهای جستجو و سایتها تعیین کنید تا عدم دسترسی به دایرکتوریهای گوناگون در هاست خودتون را تعیین کنید. اما برای استفاده از هر ربات ابتدا لازمه تا با لیست رباتهایی که تا به امروز ساخته شدند آشنا شوید. برای این کار میتونید با کلیک روی دکمه زیر کلیه رباتهای اینترنتی که تا به امروز برای خزش سایتها ساخته شدند دسترسی داشته باشید.

مشاهده کلیه رباتهای اینترنتیUser-agent: با استفاده از این دستور میتونید تا یک قانون را برای همه ربات ها و یا یک ربات خاص تعیین کنید. به عنوان مثال اگر شما داخل هاستتون پوشه ای با نام mizbanfa دارید و میخواین که دسترسی به این پوشه برای کلیه رباتها فراهم نباشه کافیه تا در سطر اول User-agent را وارد کرده و مقدار اون را روی کاراکتر * تعیین کنید و بعدش با دستور /disallow: /mizbanfa دسترسی به این پوشه را برای کل رباتها غیرفعال کنید. در این صورت هر رباتی که وارد سایت شما بشه از این قانون تبعیت کرده و وارد پوشه mizbanfa در هاست شما نخواهد شد. پس به صورت کلی ساختاری که برای این حالت تعیین میکنید باید دستور زیر را در فایل robots.txt وارد کنید. برای این کار کافیه تا روی فایل robots.txt که در هاست شما قرار داره راست کلیک کرده و گزینه Edit را انتخاب کنید.

User-agent: * Disallow: /mizbanfa/

تعیین سطح دسترسی به ربات خاص با فایل robots.txt وردپرس

همه ما ممکنه تا گاهی به این نیاز پیدا کنیم تا تصویری را در هاست خودمون آپلود کنیم و در اختیار دیگران قرار بدیم که نمیخوایم این تصویر در دسترس عموم کاربران قرار بگیره و به عبارت دیگه دیگران وارد حریم خصوصی ما نشن، بنابراین برای اینکه این تصویر توسط موتورهای جستجو ایندکس نشه باید از طریق فایل robots.txt اقدام کنیم. خب حالا شاید بپرسید که برای اینکار باید از کجا شروع کیم.

خب همونطور که در سایت robotstxt.org دیدید ما یک لیست بزرگ از رباتهای مختلف را داریم. گوگل هم بر همین اساس دارای رباتهای گوناگونی هستش که هر کدوم از این رباتها وظیفه بررسی و خزش محتوای خاصی از سایتها را دارند. به عنوان مثال معروفترین ربات گوگل که با نام Googlebot شناخته شده وظیفه بررسی و ایندکس صفحات را داره که بعد از ثبت سایت در گوگل کار خودش را برای سایت ما آغاز میکند. یا ربات Googlebot-image وظیفه بررسی و ایندکس تصاویر را داره که در این مثال ما باید از این بات برای غیرفعال کردن دسترسی این بات به تصویر خودمون استفاده کنیم.

بنابراین مشابه مثال قبل ابتدا با استفاده از دستور User-agent ربات خودمون را تعیین میکنیم. در اینجا چون شامل یک ربات هست دیگه نباید از ستاره استفاده کرد و باید نام ربات را بنویسیم بعدش در خط بعدی هم با استفاده از دستور Disallow دسترسی به پوشهای که تصویر در اون قرار داره را لغو میکنیم. به صورت کلی دستور ما مشابه زیر خواهد بود.

user-agent: Googlebot-image disallow: /mizbanfa/

در اینجا mizbanfa هم همون پوشه ای هست که تصویر در این مسیر از هاست قرار داره. بنابراین بعد از ذخیره کردن فایل دیگه ربات گوگل همچین آدرسی را مورد بررسی قرار نداده و تصویر شما توسط گوگل ایندکس نخواهد شد.

لیست کلیه دستورات قابل استفاده در robots.txt

تا اینجای کار دونستید که برای تعیین دسترسی برای هر ربات کافیه تا با دستور user-agent اونو تعیین کنید. اگر ربات خاصی مد نظرتونه نام ربات را وارد کنید اما اگر همه رباتها مدنظر شماست کافیه تا مقدار این دستور را روی * قرار بدین. برای هر قانونی که تعیین میکنید باید از user-agent جدا استفاده کنید و سپس مسیری که میخواهید تا دسترسی به اون را لغو کنید را بر اساس زیر وارد کنید.

اگر قصد دارید تا دسترسی به کل سایت را غیرفعال کنید میتونید از مشابه دستور زیر برای Disallow استفاده کنید.

Disallow: /

برای عدم دسترسی به یک پوشه خاص کافیه تا نام اون پوشه و یا زیر پوشههای اونو وارد کنید.

Disallow: /blog/ Disallow: /blog/file/

برای محدود کردن به دسترسی به یک فایل میتونید تا به شکل زیر عمل کنید.

Disallow: /images/dogs.pdf Disallow: /files/project.pdf

برای محدود کردن فایلهایی به فرمت خاص در کل سایت میتونید تا از دستور زیر استفاده کنید.

Disallow: /*.gif$ Disallow: /*.pdf$ Disallow: /*.docs$

ثبت فایل robots.txt در گوگل

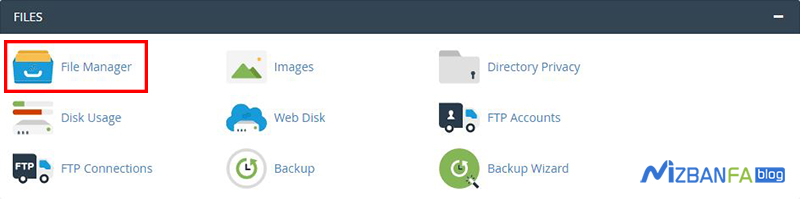

برای ثبت این فایل ابتدا باید وارد آدرس https://www.google.com/webmasters بشید و سپس روی دکمه Sign In کلیک کنید تا وارد کنسول جستجوی گوگل شده و سپس سایت خودتون را که با استفاده از آموزش ثبت سایت وردپرسی در گوگل ثبت کردید انتخاب کنید.

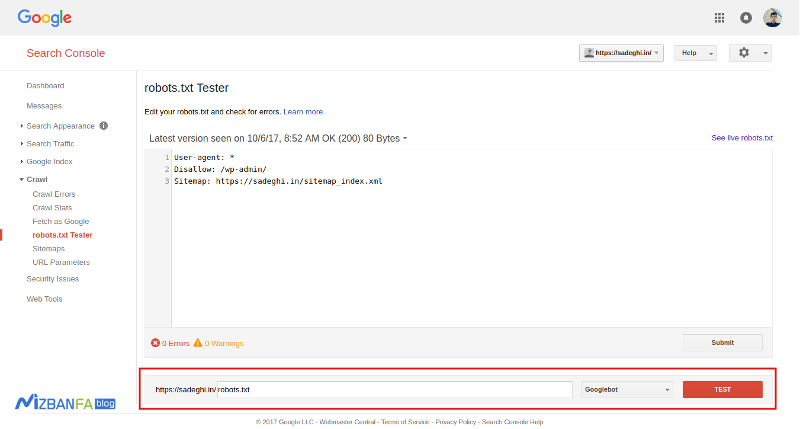

بعد از اینکه سایت خودتون را انتخاب کردید مشابه تصویر زیر به مسیر Crawl> robots.txt Tester مراجعه کنید.

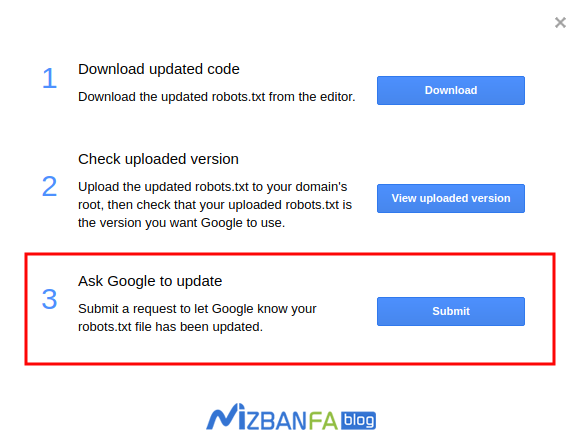

مشابه تصویر در فیلد مشخص شده عبارت robots.txt را وارد کنید و روی دکمه TEST کلیک کنید تا با پیغام سبز رنگ Allowed مواجه بشید. اگر درست بود حالا محتویات فایل robots.txt را وارد ویرایشگری که میبینید بکنید و روی دکمه Submit کلیک کنید تا پنجره زیر براتون باز بشه.

خب در اینجا ما چون از قبل فایلرا در هاست اپلود کردیم با کلیک روی دکمه Submit گزینه سوم را انتخاب کنید.

بهینه سازی فایل robots.txt وردپرس

حالا که با ساختار فایل robots.txt وردپرس آشنا شدید در ادامه به معرفی راههایی برای بهینه سازی robots.txt میپردازم تا با استفاده از این راهها سئو وردپرس خودتون را بهبود دهید.

یکی از باورهای غلط که در بین وبمستران مشاهده میشه اینه که با استفاده از این فایل باید صفحات بی کیفیت مثل آرشیو و دستهبندی را از دسترسی به رباتهای جستجوگر غیرفعال کنند. باید گفت که در رابطه با نه تنها وردپرس بلکه هیچ CMS دیگه ای این گفته درست نیست. چرا که آدرسهایی مثل آرشیو، برچسب، دستهبندی و… در وردپرس در حکم یک پوشه یا دایرکتوری نیستند که با استفاده از این روش بتونید دسترسی به اونها را غیرفعال کنید. بلکه این آدرها از طریق دیتابیس تعیین شدهاند و عملا پوشهای با نام category یا tag در هاست شما وجود نداره که با استفاده از این روش بخواهید دسترسی را محدود کنید.

اگر که شما قصد دارید تا صفحات خاصی را از دسترسی رباتهای جستجوگر غیرفعال کنید کافیه تا با استفاده از افزونههایی نظیر سئو وردپرس این کار را انجام بدین که قابلیت Noindex در اونها قرار داره که در مقالهای جامع به معرفی این کارها خواهم پرداخت.

چند نکته درباره فایل robots.txt

نکته اول: صفحاتی مثل صفحه ورود وردپرس و صفحه پیشخوان وردپرس که به ترتیب در آدرسهای wp-login.php و wp-admin در دسترس هستند به صورت پیشفرض در حالت Noindex هستند، بنابراین نیازی نیست تا با استفاده از فایل robots.txt دسترسی به این دو صفحه را محدود کنید.

نکته دوم: نقشه سایت یا Sitemap خود را در این فایل مشابه نمونه زیر وارد کنید تا وقتی رباتهای جستجوگر فایل robots.txt را بررسی میکنند نقشه سایت را مشاهده کرده و قبل از هر صفحه از سایت این صفحه را مورد بررسی قرار دهند تا سرعت ایندکس صفحات شما بیشتر شود. برای این کار کافیه تا دستور زیر را در خط انتهایی این فایل وارد کنید.

Sitemap: http://mizbanfa.net/post-sitemap.xml Sitemap: http://mizbanfa.net/page-sitemap.xml

نکته سوم: فایل readme.html را با استفاده از فایل robots.txt در حالت محدود قرار دهید. چرا که برخی افراد سعی میکنند تا با استفاده از این فایل اطلاعاتی مثل نسخه مورد استفاده از وردپرس و… را که معمولا توسط ربات این کارها انجام میگیره به دست آورده و با استفاده از آن شروع به کارهای مخرب روی سایت شما بکنند. هرچند که راههای بسیار زیادی برای دونستن نسخه مورد استفاده وجود داره اما اگر سایر راهها را بسته باشید و تنها این راه بر سر راه فرد قرار گرفته باشه با این روش هم دیگه قادر نخواهد بود تا نسخه وردپرس مورد استفاده شما را بدونه و برای این کار کافیه تا دستور زیر را برای کلیه رباتها تعیین کنید.

Disallow: /readme.html

نکته چهارم: دسترسی به دایرکتوری افزونههای وردپرس را محدود کنید. با استفاده از این کار دایرکتوری که افزونههای وردپرس در اون قرار دارند ایمن شده و مشابه همون فایل readme.html براش اتفاق افتاده و میشه امنیت سایت خودتون را افزایش بدین. برای این کار کافیه تا دستور زیر را به فایل robots.txt اضافه کنید تا دسترسی به پوشه افزونه های وردپرس از رباتها مصون بماند.

Disallow: /wp-content/plugins/

نمونه یک فایل robots.txt مناسب

احتمالا تا اینجای آموزش این سوال برای شما هم پیش اومده که یک فایل مناسب و نمونه فایل robots.txt که باید ازش استفاده کنیم به چه صورتی میتونه باشه؟ در پاسخ به این سوال میتونید از نمونه زیر استفاده کنید و بعدش با شخصی سازی اون و اعمال تغییرات بر اساس همین آموزش دسترسی به پوشهها مختلف در هاست خودتون را کنترل کنید.

User-Agent: * Disallow: /wp-content/plugins/ Disallow: /readme.html Sitemap: http://mizbanfa.net/post-sitemap.xml Sitemap: http://mizbanfa.net/page-sitemap.xml

اگه می تونید یه مقاله در مورد اینکه چجوری باید به بعضی ها دسترسی های خاصی بدیم بذارید

مثلا برای یه فرد تعیین کنیم فقط بتونه به چند افزونه دسترسی داشته باشه

سلام، روز بخیر علی آقا

مقاله منتشر شد، میتونید با مراجعه به آموزش تعیین سطح دسترسی کاربران در وردپرس مطالعه و ازش استفاده کنید. امیدوارم که براتون کاربردی باشه.

موفق باشید 🙂

سلام این مطلب خیلی عالی بود. کلی دنبالش گشتم دستتون درد نکنه

سلام خسته نباشید من از فایل robots سایت شما استفاده کردم راضی باشید .تشکر

سلام و وقت بخیر، ما راضی هستیم?، فقط مجددا یه بازبینی داشته باشید و استفاده کنید. اصلاحش کردیم:)

سلام وقت بخیر خوبید ان شالله.این رو تایید نکنید لطفا خواستم از طریق تماس با ما ارسال کنم که به مشکل خوردم نشد متاسفانه . من دنبال یه قالبی شبیه به این قالب هستم شما جایی دیدید؟میتونید طراحی کنید با قیمت ارزون 🙂

divar.ir/blog

خیلی ممنونم

باتشکر

شایان

سلام و وقت بخیر،

با همین قالب فعلی که در پایگاه دانش میزبانفا استفاده میشه میتونید با همین شکل و شمایل یک وبلاگ ایجاد کنید. ما از قالب جنه استفاده میکنیم.

در حال حاضر برنامهای برای طراحی سایت یا قالب در میزبانفا نداریم، میتونید از شرکتهای طراحی سایت این درخواست را ارسال کنید که به صورت اختصاصی مشابه همین قالب را براتون راهاندازی کنند.

موفق باشید 🙂

خیلی ممنونم بابت راهنماییتون چرا تایید کردید ؟ 🙁

خواهش میکنم، برای اطلاع از پاسخ دیدگاه بوده 😀

ما این قالب را به صورت اورجینال از خود تم فارست خریداری کردیم. برای خرید میتونید به آدرس https://themeforest.net/item/jannah-wordpress-news-magazine-theme/19659555 مراجعه کنید.

باسلام نسخه ی کامل و فول با اپدیت همیشه از سایت

در ضمن این کامل میباشد مستقیم از سایت قالب دریافت و در سایت قرار گرفته است

در ضمن برای اپدیت هر وقت که اپدیت انتشار شود از سایت میتوانید دانلود کنید و نصب کنید

سلام من چون قالبم خاصه نمیخوام پوشه قالبمو بررسی کنه بنظرتون اگه پوشه wp-theme رو محدود کنم بضررمه ؟ ممنون میشم زود بگین

سلام و وقت بخیر، خیر مشکلی از این بابت بوجود نمیاد.

سلام حالا اگر محدود نشود چه مشکلی پیش میاد؟

تشکر

مشکلی که پیش میاد اینه که شما به ربات گوگل دسترسی را دادین، بنابراین این مسیر را چک میکنه، چون با خطا مواجه میشه امتیاز منفی برای سایت خواهد داشت.

گوگل میره قالب سایت وردپرس رو هم بررسی میکنه؟

بعد که قالب رو بررسی میکنه چرا باید با خطا مواجه بشه؟ متوجه نشدم.

سلام اکثر خطاهای من تو گوگل وبمستر ناشی از wp-includes هستش اگه تو ربات دسترسیش رو قطع کنم مشکلی پیش میاد

نمونه خطاهایی که پیش میاد:

wp-includes/customize/class-wp-customize-nav-menu-location-control.php

wp-includes/rest-api/fields/class-wp-rest-user-meta-fields.php

wp-includes/rest-api/endpoints/class-wp-rest-users-controller.php

سلام و وقت بخیر،

پوشه wp-includes نیازی به دسترسی توسط رباتهای گوگل نداره و اگر سایتهای بزرگ وردپرسی رو بررسی کنید میبینید که دسترسی به این پوشه منع شده

سلام، وقت بخیر، یعنی دسترسی به wp-includes را محدود کتیم؟ این محدودیت سازی ها تاثیری بر روی سئو سایت نداره؟

سلام، بله میتونید محدود کنید.

خیر این موضوع ارتباطی با سئو نداره.

داش عباس خیلی ممنونم واقعا از زحمتت و پاسخگویی بی منتت

الان با راهنمایی شما

User-agent: *

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /readme.html

Allow: /wp-admin/admin-ajax.php

Allow: /wp-content/uploads/

به این شکل ربات رو نوشتم،فقط اتفاقی داشتم پوشه افزونه ها رو نگاه میکردم دیدم یه فایل htaccess توش هست که داخلش

Options -Indexes نوشته بود فقط،این اثر رباته یا اشتباها تو اون پوشه هستش؟

بازم ممنون

خواهش میکنم ناصر جان، این کد که داخل فایل htaccess. هست احتمالا توسط یه افزونه امنیتی که استفاده میکنی اضافه شده که وظیفش اینه که از خوندن و مشاهده صفحه پوشهها جلوگیری میکنه که اگر کسی وارد آدرس پوشه افزونهها(site.com/wp-content/plugins) شد نتونه پوشه افزونهها و فایلهای داخل این مسیر رو ببینه. چیز خوبی هست، بهتره ازش استفاده کنی.

دم شما گرم خدایی

الان من سایت خودتون رو هم چک کردم یه خطایی که هست

wp-admin/admin-ajax.php

برای مثال این آدرس رو چک کن

https://mizbanfa.net/wp-admin/admin-ajax.php

لود نمیشه و صفحه رو که باز میکنی صفر میاره،اینم از سری خطاهای وبمستره که آورده بود برام یکی دو تا سایت دیگه رو هم چک کردم الان این ایراده به نظرت؟

وردپرس تا نسخه 4.4 از دسترسی گوگل به admin-ajax.php جلوگیری میکرد و به همین خاطر لازم بود تا به صورت دستی این دسترسی داده بشه، بعد از نسخه 4.4 طبق تیکتی که تیم یوست برای وردپرس ارسال کردن این مورد برطرف شده و دسترسی بهش داده میشه.

اگر خطای دسترسی ajax از گوگل دریافت میکنید بهتره به صورت دستی این کار رو انجام بدین، قرار دادنش مشکلی ایجاد نمیکنه.

معذرت میخوام واقعا کامنت ها هم طولانی شد، اما چجوری میشه این رو درستش کرد،ینی همینجوری بمونه موردی نداره؟یا منظورتون از اینکه دستی دسترسی بدم باید دقیقا چیکار کنم؟تو ربات که دسترسی مجازه ولی همون تو باز شدن 0 هستش

آره، تو فایل robots.txt همینطور بزارید در حالت allow بمونه. مقدارش مهم نیست چی باشه

سلام .من تمامی کارهایی که شما گفتید رو مو به مو انجام دادم. اما سایتم هیچ صفحه ایش index نشده

و فقط submit شده. خیلی عجیبه

عالیه

سلام

میخواستم بدانم از نظر شما فایل robots.txt به صورت زیر مناسب هست به خصوص اون قسمت که گفته شده Disallow: */comments/ آیا منطقی هست ؟

Sitemap: http://site.com/sitemap.xml

# Google Image

User-agent: Googlebot-Image

Disallow:

Allow: /*

# Google AdSense

User-agent: Mediapartners-Google*

Disallow:

# digg mirror

User-agent: duggmirror

Disallow: /

# global

User-agent: *

Disallow: /cgi-bin/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/cache/

Disallow: /wp-content/themes/

Disallow: /trackback/

Disallow: /feed/

Disallow: /comments/

Disallow: /category/*/*

Disallow: */trackback/

Disallow: */feed/

Disallow: */comments/

Disallow: /comments/feed

Disallow: /*?

Allow: /wp-content/uploads/

سلام، این فایل زیاد درست نیست و دسترسی به بعضی بخشها بسته شده در صورتی که بهشون نیازی نیست. کامنتها جزوی از محتوای صفحه شما به حساب میان و میتونن توی جستجو کردن کمک کنن، به خصوص با آپدیت جدید که توضیحات متا صفحات رو گوگل خودش توی نتایج بر اساس جستجوی کاربر نشون میده.

تشکر بابت پاسخگویی به نظرتون به قسمت زیر نیاز هست یا خیر ؟

Disallow: */feed/

خیر نیازی به این کار نیست. فید سایت برای برخی رباتهای جستجوگر نیاز هست.

سلام خیلی مفید بود

من دوتا سوال داشتم

شما توی نمونه فایل قسمت پلاگین رو Disallow کردین ولی وقتی این قسمت رو قرار میدیم گوگل سایت رو به صورت ریسپانسیو نمیشناسه در صورتی که سایت ریسپانسیو هست

و سوال بعدی اینکه من تمام این کاراو انجام دادم و در آخر submit هم زدم ولی هنوز همون فایل robots قبلی رو اجرا میکنه یعنی تغییرات اعمال نمیشه

مشکل از کجاس ؟

سلام، اگر که با محدود کردن افزونهها این حالت رخ میده و با ابزار fetch as google چیزی که به کاربر نشون داده میشه و چیزی که گوگل نشون میده متفاوت هست این کار رو انجام ندین.

چک کنید که فایل robots.txt رو هم آپدیت کرده باشید. گاهی اوقات کمی زمان میبره که اصلاح بشه.

سلام وقت بخیر .

خسته نباشید ببخشید این پاسخ دیدگاه ها به ایمیل من میاد همیشه باید چه کار کنم که دیگه نیاد؟

تشکر

سلام، زیر باکس متن دیدگاه روی لینک مدیریت اشتراک کلیک کنید و اشتراک دریافت نظرات رو لغو کنید.

عالی بود ممنون

از اینکه میزبان فا بعنوان مرجع یادگیری منه ازتون تشکر می کنم

سلام

اگه با یه افزونه ادرس پوشه ادمین رو تغییر بدیم باید تو فایل روبات ادرس تغییر داده شده رو بدیم یا همون wp-admin ؟

سلام، وقتی آدرس پوشه ادمین رو تغییر میدین برای زمانی هست که میخواین تو وردپرس لاگین کنید. یعنی وقتی که لاگین میکنید صفحه پیشخوان وردپرس با wp-admin در دسترس هست و فقط موقع ورود آدرس عوض میشه.

نیازی به معرفی آدرس نیست و همین wp-admin باید باشه.

سلام . ببخشید سوالی داشتم

چرا فایل ربات شما پیدا نیست و اگر من هم بخوام کسی نتونه فایل رباتمو نگاه کنه باید چکار کنم ؟

فایده مخفی کردن فایل چیه ؟

سلام، این فایل در دسترس هست و مشکلی نیست. فایل robots.txt نباید هیچوشت از دسترس خارج بشه.

با سلام من قبلا دسترسی موتور های جستجو را از تنظیمات خواندن بسته بودم

حالا باز کردم اما باز هم کد

User-agent: *

Disallow: /

در http://alidada-co.com/robots.txt دیده میشود . با اینکه فایل robots.txt در روت هاست ساختم اما در سرچ کنسول و هم در ادرس بالا محتویات تغییر نمیکنند.

مسئله بعدی اما در ادرس سایت با www

http://www.alidada-co.com/robots.txt

محتویات فایل به شکل زیر است

User-agent: *

allow: /

البته نشانی وردپرس رو هم بدون www قرار داده ام

مشکل اینکه فایل ربات بر روی موتور های جستجو کلا بسته است

ایا این فایل داینامیک تولید میشه از کجا میشه تغییر داد؟

از افزونه سئو وردپرس استفاده میکنم

سلام، این فایل رو باید به صورت دستی ویرایش کنید. مراحل ساختش رو هم از نو شروع کنید و طبق آموزش انجام بدین.

یک سوال برام پیش اومد مگه ما نقشه سایت را باید با دبلیو و در بدون دبلیو داخل گوگل ثبت کنیم یا فقط دامنه ای که میخواهیم ازش استفاده کنیم ؟

2- واین دستور چه معنی داره منظورم دستور Allow: / چه معنی میگیره

Disallow: /wp-settings.php

Allow: /

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content

3= من از قالب اوادا استفاده میکنم پلاگین را مسدود کنم مشکلی نیست درسئو ؟

خیلی نیاز مند جواب شما عزیز بزرگوار هستم لطفا سوال پایین را هم جواب بدید

سلام روزبخیر؛

قطعه کدی که ارسال کرید مانع دسترسی ربات ها به دایرکتوری هایی میشه که در کد نام برده شده.

چه پلاگینی رو تمایل دارید مسدود کنید؟ امکان محدود کردن دسترسی ربات ها به دایرکتوری یا ادرس های خاص میسره و مشکلی برای سایت نیست.

سلام وقت بخیر.

فقط یه سوال

Disallow: /wp-content/plugins/

وقتی این کد رو اضافه کنیم برای افزونه هایی مثل یواست سئو و گوگل سایت مپ مشکلی پیش نمیاد؟

سلام، خیر مشکلی نداره.

سلام میزبانفا عزیز

این مطلب برای من بسیار مفید بود و استفاده کردم. امیدوارم که همواره با انرژی و حال خوب ادامه بدید و موفق باشید

با سلام به کادر مجرب میزبان فا

یه مشکل تو ثبت ربات تست گوگل وبمستر دارم هر کاری میکنم دکمه submitرو میزنم این انو نشون میده

It didn’t go through. Try again later.

میشه راهنمایی کنید

با سلام دوست عزیز

این احتمال وجود دارد که فایل مربوط به نقشه سایت شما دچار مشکل باشد. در چنین شرایطی پیشنهاد من به شما این است که دوباره فایل مربوطه را تهیه نمایید یا از ابزارهای کمکی برای معرفی سایپ مپ خود به گوگل استفاده نمایید. در همین راستا شما می توانید مقاله آموزش ثبت سایت مپ در گوگل وبمستر را مطالعه نمایید.

موفق و پیروز باشید

سلام بنظرتون این کامله ؟

User-agent: *

Disallow: /wp-admin

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /wp-includes/js

User-agent: *

Disallow: /wp-admin

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /wp-includes/js

سلام

Disallow: /*add-to-cart=*

Disallow: /dl/

این کدها برای چی هست ؟

آیا نیازی هست اینارو قرار بدیم؟

سلم روزبخیر؛

اگر تمایل به محدود کردن آدرس خاصی ندارید نیاز به درج کد نیست.

سلام من میخوام محصولاتمم ایندکس شه اینجوری نوشتم:

User-Agent: *

Disallow: /wp-content/plugins/

Disallow: /readme.html

Sitemap: ***/post-sitemap.xml

Sitemap: ***/product-sitemap.xml

Sitemap: ***/page-sitemap.xml

درسته؟

با سلام دوست عزیز

در صورت استفاده از کد فوق شما دسترسی به پوشه های فوق را برای کل رباتها غیرفعال می کنید. در صورتی که می خواهید تمامی بخش ها و صفحات وب سایتتان ایندکس شود باید کدهایی که با عنوان disallow وجود دارد را از فایل robots.txt خود حذف نمایید.

موفق ویروز باشید

سلام، ببخشید تفاوت قرار دادن و ندادن اسلش انتهای آدرس چیست؟

Disallow: /wp-content/plugins/

Disallow: /wp-content/plugins

جایی خونده بودم اگه از / در انتهای آدرس استفاده بشه ربات نمیتونه به پوشه های بعدی دسترسی داشته باشه یا بالعکس اگه از / استفاده نشه میتونه به پوشه های بعدی دسترسی پیدا کنه، هرچند اگه Disallow باشه؛ البته این احتمال هم هست که من جابجا گفته باشم. ممنون میشم این مورد را برای ما روشن کنید.

سلام روزبخیر؛

وجود کاراکتر / انتهای آدرس در فایل robots.txt باعث میشه تفاوت های اساسی در محدودسازی صورت بگیره مثال:

_______________________

Disallow: /messages

URL هایی مانند نمونه های زیر را مسدود می کند:

https://example.com/messages

https://example.com/messages.html

https://example.com/messages/

https://example.com/messages/foo

_______________________________

اما در نمونه Disallow: /messages/

URL هایی مانند موارد زیر را مسدود می کند:

https://example.com/messages/

https://example.com/messages/foo

در این حالت موارد زیر ازاد هستن:

https://example.com/messages

https://example.com/messages.html

امروز چندتا نظر دادم تو سایت شما عجیبه 🙂

دوست عزیز ایا خود افزونه yoast اینکار رو نمیکنه؟

مهندس من فروشگاه اینترنتی دارم ولی محتوای سایتمو در هاست دانلود آپ میکنم بنابر این آیا برای سایت اصلیم هم نیازه تا robots.txt بسازم؟؟؟

واینکه برای هاست دانلودم باید این مورد بسازم درسته؟

سلام من آدرس مپ سایت رو به گوگل سرچ کنسول دادم اما “کودنت فچ “میزنه ربات هم طبق راهنما ساختم اما بازم فچ نمیشه باید چیکار کنم؟ این ارور هم میده موقعی که بر روی راهنمای ارور کلیک میکنم میاد:

We encountered an error while trying to access your Sitemap. Please ensure your Sitemap follows our guidelines and can be accessed at the location you provided and then resubmit.

سلام من آدرس مپ سایت رو به گوگل سرچ کنسول دادم اما “کودنت فچ “میزنه ربات هم طبق راهنما ساختم اما بازم فچ نمیشه باید چیکار کنم؟ این ارور هم میده موقعی که بر روی راهنمای ارور کلیک میکنم میاد:

We encountered an error while trying to access your Sitemap. Please ensure your Sitemap follows our guidelines and can be accessed at the location you provided and then resubmit….

با سلام دوست عزیز

طبق محتوای ارائه شده گوگل امکان دسترسی به سایت مپ شما را ندارد. شما می توانید از مقاله آموزش ساخت سایت مپ در وردپرس یا مقاله آموزش ساخت و معرفی نقشه سایت xml وردپرس در گوگل استفاده نمایید.

موفق و پیروز باشید

سلام وقت بخیر

من تمامی مراحل رو همونطور که گفتید انجام دادم و نمونه robots هم شده این

User-Agent: *

Disallow: /wp-content/plugins

Disallow: /readme.html

Sitemap: http:***/sitemap_index.xml

Sitemap: http:***/sitemap_index.xml

داخل robots tester میزنم allow میشه اما موقع submit کردن که گزینه سوم رو میزنم این پیغام رو میده It didn’t go through

صفحه نخست سایتم کلا ایندکس نمیشه میگه crawler has been blocket و اینکه سایت مپ هم که داخل search console میزام اررو couldnt fetch رو میده

چی کار کنم به نظرتون ؟؟

ممنون میشم راهنمایی کنید

User-agent: *در صورتی که این کد در فیل robot.txt شما قرار گرفه باشد نشان دهنده این موضوع است که شما دسترسی به محتوای وب سایت خود را برای تمامی رباتهای جستجوگر بسته اید. در واقع شما با دستور disallow اعلام کرده اید که دسترسی به آدرس /wordpress/post-name/ که بعد از آدرس دامنه قرار داره از رباتها سلب بشه و ایندکسی در این صفحات صورت نگیرد. در همین راستا باید این کد را حذف نمایید تا محتوا از حالت مخفی دربیاید.Disallow: /wordpress/post-name/

موفق و پیروز باشید

سلام به نظرم مطلب بالا یه مشکلی داره از یه طرف گفتین که در فایل روبات فایل readme.html را دسترسی به موتور های جستجو ندین درصورتی که وقتی روی میزبان فا یک سایت وردپرسی به صورت خودکار درست میکنیم سطح دسترسی 755 به فایل readme.html داده میشود خوب حالا ما مثلا برای موتور های جستجو هم این موضوع را ببندیم آخرش کسی که بخواد کار مخرب انجام بده به راحتی میتونه به فایل دسترسی داشته باشه و فایل را مشاهده کنه پس چه سودی داره که ما بخوایم برای موتور های جستجو دسترسی به این فایل را ببندیم؟؟؟

سلام روزبخیر؛

تعیین سطح دسترسی فایل و دایرکتوری ها طبق نظر و سلیقه کاربر توسط خودشون انجام میشه بهتره این فایل محدود باشه تا نسخه وردپرس مورد استفاده مخفی بمونه.

سلام و عرض ادب

من یک سایت اصلی در پوشه public_html دارم و با استفاده از اددآن دامین یک سایت هم در یک پوشه اختصاصی در دایرکتوری ریشه راه اندازی کرده ام.

فایل robots.txt را باید در کدام پوشه قراردهم؟ برای هر سایت در پوشه خودش؟

با تشکر از آموزش خوبتون

خیلی ممنونم از آموزش کامل و جامعتون

سلام فایل را ساختم عین همین که نوشتین:

/post-sitemap.xml Sitemap May 7, 2020 May 7, 2020 Success 16

/page-sitemap.xml Sitemap May 7, 2020 May 7, 2020 Success 15

ولی robots.txt در سرچ کنسول خطا میده :

/robots.txt Unknown May 7, 2020 May 7, 2020 1 error 0

خطا هم اینه :

Sitemap can be read, but has errors

Unsupported file format

با سلام

من با تایپ آدرس فایل robots.txt میتونم اون رو مشاهده کنم ولی وقتی برای ویرایشش به پوشه public html در دایرکت ادمین میرم، فایلی با همچین نامی وجود نداره تا بتونم ویرایشش کنم.

با تشکر.

سلام روزبخیر؛

این فایل در روت سایت قرار گرفته می تونید فایل رو مجددا ایجاد کنید مشکلی نداره و سپس فایل جدید رو به گوگل معرفی کنید. قسمت ثبت فایل robots.txt در گوگل در همین مقاله رو مطالعه کنید.

سلام وقتتون بخیر

من یه سری برگه به صورت پیشفرض روی قالب دارم که منتشر شده و نمیخواهم هم حذفشون کنم . آیا میشه تو فایل robot.txt بگم که این برگه ها رو ایندکس نکنن؟ چطوری نشونی بدم؟

سلام روزبخیر؛

بله می تونید دسترسی ربات ها به ادرس های دلخواه رو محدود کنید.

می تونید راهنمای آموزش مخفی کردن مطالب وردپرس از نتایج گوگل رو مطالعه کنید.

سلام وقتتون بخیر

چطور تو فایل robot.txt دسترسی به برگه های پیش فرض قالب رو محدود کنم….(قالب رو نصب کردم و یه سری برگه به صورت پیش فرض نصب شده که نمیخاوهم حذف بشن)

لطفا راهنمایی کنید

سلام روزبخیر؛

اگر صفحات خاصی رو در نظر دارید تا محدود بشه باید به شکل زیرعمل کنید:

در واقع آدرس صفحه رو بدون دامنه اصلی مینویسید:

Disallow: /youraddress/

سپاسگزارم

یه سوال دیگه اینکه

تو سرچ کنسول جدید گزینه ای که باید فایل robot رو ثبت کنم پیدا نمیکنم

لطفا راهنمایی فرمایید.تشکر

سلام

در سرچ کنسول جدید جایی برای ثبت رباتtxtنیست.چه باید کرد؟

سلام و ممنون از سایت خوبتون

یک سوال داشتم

تو قسمتی که گفتید نقشه سایت رو به ربات اضافه کنیم

Sitemap: http://mizbanfa.net/post-sitemap.xml

لازمه که از https:// استفاده کنیم یا ن ؟

چون سایت رو با https:// به گوگل وبمستر معرفی کردیم http بودن این لینک مشکلی ایجاد نمی کنه ؟

سلام روزبخیر؛

در سرچ کنسول گوگل 4 نوع یا نسخه از سایت ممکنه تعریف بشه:

سایت با www

سایت بدون www

سایت با پروتکل http

سایت با پروتکل https

حلا موقع ارائه سایت مپ در سرچ کنسول بر اساس نسخه سایتتون باید عمل کنید. مثلا اگر از پروتکل https استفاده میکنید کنار فیلد معرفی سایت مپ یک لینک نمونه براتون به صورت لیبل نمایش داده میشه که اون لینک با https شروع شده.

سلام من مشکل بزرگ دارم اونم این هست که من چند پست رو خذف کردم از سایتم و اونها در گوگل ثبت شده اند و پاک نمیشوند وخطای 404 در سایتم میدهند است و من از طریق Removals هم برداشتم ولی نمیرن مثال تصویر زیر را ببینید که من ان ها را پاک کردم

حتب بعضی ازلینک ها که پاک نشد دو بار زدمشون ولی پاک نشدن منتظر هستم این مشکلم برطرف بشه تا شروع به کار پست گزاری و شروع فعالیت کنم

درضمن یکی از دوستان من هم همین مشکلو داشتن که نمیدونم چه کار کردند که بعد ازچند روز مشکلش حل شد ولینک های قدیمی و خالی رفتند ازش پرسیدم ایا از قسمت Removals برداشته ای میگوید خیر بخش Removalsفقط

برای شش ماه پاک میکند من هم نمیدانم چه کنم تازه از دیروز درخواست پاک کردن لینک ها را داده ولی من سه روزی میشود درخواست داده ام ولی اتفاقی نمیافتد این هم بزرگترین مشکل من است

سلام روزبخیر؛

به کمک زبانه Removals شما URLهایی را که از طریق نتایج سرچ به دست آورده اید یعنی صفحات ایندکس شده وب سایت خود را پاک کنید. برای پاک کردن محتوا به طور دائم باید صفحه مربوط به آن URL را پاک کرد یا به روز رسانی کنید. به همین منظور تنها کافی است URL صفحه ای که می خواهید آن را حذف کنید را در این زبانه وارد نمایید تا محتوا آن حذف شود. قسمت «temporary hide» برای عدم دسترسی به صورت موقت برای 6 ماه هست.

سلام وقت بخیر

من سایتمو در سرچ کنسول ثبت کردم و بعضی از صفحاتش ایندکس شده اما بنا به دلایلی منصرف شدم و فعلا نمیخام سایت فعلا بازدید کننده داشته باشه ایا دسترسی ربات ها رو ببندم بهتره یا به حالت Maintenance بزارمش ؟کدوم روش بهتره و به سایتم ضرری وارد نمیکنه ؟

سلام روزبخیر؛

اگر تمایل دارید کاربران سایت رو ببیننن اما صفحات ایندکس نشه دسترسی ها رو در robots.txt محدود کنید.

اما اگر تمایل دارید کاربری سایت شما رو بازدید نکنه از طرفی رات ها هم سایتتون رو ایندکس نکنن سایت رو در حالت تعمیر و همچنین نوایندکس قرار بدید.

حالت تعمیر به تنهایی کافی نیست و فقط برای محدودیت بازدید از سمت کاربران مفیده.

سلام وقت بخیر:

برای جلوگیری از ایندکس کردن یه لینک و زیر مجموعه های آن باید کد را چجوری بنویسیم به طور مثال:

عدد اخر ا مربوط به کد رنگ ها هستن میخوام از colors به بعد را ایندکس نکنه

این و همه زیرمجموعه های این لینک را ممنوع به ایندکس کنه.

سلام

چند وقتی هست که سایتم به طوری عجیبی بازدید فیک میخوری یعنی مثلا 1000 تا بازید کننده دارم 5000 تا بازدید میخوره که فک کنم برای سایت بد باشه ، تو اینترنت هرچی سرچ کردم چیر بدردبخوری نبود لطفا یک آموزش در این باره بزارید یا من رو راهنمایی کنید ممنون

سلام

چند وقتی هست که سایتم به طوری عجیبی بازدید فیک میخوری یعنی مثلا 1000 تا بازید کننده دارم 5000 تا بازدید میخوره که فک کنم برای سایت بد باشه ، تو اینترنت هرچی سرچ کردم چیر بدردبخوری نبود لطفا یک آموزش در این باره بزارید یا من رو راهنمایی کنید ممنون.

سلام روزبخیر؛

گهی اوقات ممکنه در نتیجه ورود ربا به وبسایت آمار و ارقام به این صورت روند صعوی عجیبی داشته باشند.

پیشنهاد میکنم روی فرم هاتون افزنه های کپچا درج کنید (فرم های ورود، ثبتنام و دیدگاه ها) و همچنین مرتب بررسی کنید روند صعودی غیرطبیعی ادامه دار نباشه و به حالت طبیعی برگرده.

سلام

میشه لطف کنید یه فایل استاندارد روبوت تکست در انتهای مقاله بذارید که مناسب سایت های خبری و مجله ای باشه؟

الان با خوندن این مقاله هنوز نفهمیدم باید فایل روبوت تکست رو چه طوری تنظیم کنم!

با سلام من برای ادد کردن سایت یک همچین پیامی میگیرم و میگه یک کد رو در صفحه اصلی کپی کنم ولی نمیدونم دقیقا ئر کدام برگه و کجا باید اضافه کنم ممنون راهنمایی بفرمایید

1. Copy the meta tag below, and paste it into your site’s home page. It should go in the section, before the first section.

2. Click Verify below.

To stay verified, don’t remove the meta tag, even after verification succeeds.

با سلام و خسته نباشید… من میخواستم دسته بندی و صفحات سایتم رو گوگل نادیده بگیره و فقط مطالبی که ارسال میکنم ایندکس کنه در این حالت باید چه کدی در فایل robots.txt قرار بدم تا هم دسته بندی و صفخات سایت من ایندکس نشن … باتشکر

با سلام دوست عزیز

شما می توانید مطابق با آموزش مخفی کردن مطالب وردپرس از نتایج گوگل اقدام نمایید و از ایندکس صفحات مورد نظر خود جلوگیری نمایید.

موفق و پیروز باشید

سلام ممنون از آموزشتون. میخواستم ببینم الان فایل robots.txt سایت من خوبه؟

سلام وقت بخیر؛

به صورت پیشفرض کد زیر درج میشه:

User-agent: *Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

شما دسترسی ب پلاگین ها را محدود و سایت مپ را معرفی نموده اید. مشکل خاصی در این فایل مشاهده نشد.

موفق باشید.

با سلام و عرض ادب

میخواستم لطف کنید بگید محتویات فایل robots.txt سایتم درست هست یا نه؟ هر کدوم نیاز به حذف و اصلاح داره رو هم بگید ممنون میشم :

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /trackback

Disallow: /comments

Disallow: */trackback

Disallow: */comments

Disallow: /wp-content/plugins/

Disallow: /readme.html

Disallow: /*?*

Disallow: /*?

Allow: /wp-admin/admin-ajax.php

Allow: /wp-content/uploads

Sitemap: ://mysite.ir/sitemap_index.xml

Sitemap: ://mysite.ir/wpms-sitemap.xml

User-agent: Googlebot

Disallow: /*/feed/$

Disallow: /*/feed/rss/$

Disallow: /*/trackback/$

سلام

یه جورایی میشه گفت ایندکس برای محدود کردن یکسری از صفحات برای ربات گوگل هستش

درسته؟

با سلام دوست عزیز

ایندکس به معنای فهرست شدن است و زمانی که می گوییم یک مطلب در گوگل ایندکس شده است یعنی آن مطلب در نتایج گوگل نمایش داده می شود. برای آشنایی بیشتر با سئو و بهینه سازی سایت می توانید در صورت تمایل مقاله فاکتور های سئو و بهینه سازی سایت + آموزش سئو را مطالعه نمایید.

موفق و پیروز باشید

سلام روزخوش ممنون میشم کمکم کنید

یه اتفاق عجیب افتاده برای ربات من که من رو نو فالو و نو ایندکس کرده وقتی وارد پنل مدیریت وردپرس میشم فاو و ایندکس میشه و مجددا بعد از یک روز سایت رو نوفالو و نوایندکس میکنه چطور این مشکل رو برطرف کنم میشه کلا ربات رو حذف کرد ؟

سلام کاربرد Disallow: /refer/

چی هست خیلی جاها دیدم ولی کاربردش توضیح داده نشده

سلام!

خواستم تشکر کنم. با آموزش شما، یه فایل تکست نوشتم به اسم robot و داخل دایرکتوری وردپرس هاست خودم آپلودش کردم…

با تشکر

سلام وقت بخیر

میخواستم بدونم اگه فقط این دو خط با نقشه سایت داخل رباط باشه چهمعنی میده

User-agent: *

Disallow:

سلام وقت بخیر؛

User-agent: * یعنی تمامی ربات ها

Disallow: نیز تعیین کننده مسیری است که ربات ها به آن دسترسی نخواهند داشت.

User-Agent: *

user-agent: Googlebot-image

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /wp-content/plugins/

Allow: /wp-admin/admin-ajax.php

Sitemap: https:/*/sitemap.xml

سلام ربات سایت استاندارد هست؟

متاسفانه بعد محدودیت ها سایت روی موبایل نمی اومد بالا سیدیان نصب کردن رو سایت حالا بازدید خیلی کم شده

راه حلی واسه بنده هست ؟

سلام خسته نباشید

ببخید من یک ساتی با لاراول طراحی کردم الان دنبال یک دستور برای نو اندکس کردن صفحه بندی ها هستم و پیدا نمیکنم اگر لمکان داره راهنمایی کنید و ئستورش رو برامون ارسال کنید. قطعا این دستور رو خیلیا دنبالشن و تو اینترنت من نتونستم پیدا کنم.

برای مثال تمامی برچسب ها و دسته بندی های سایت بعد از 10 مقاله صفحه بندی میشن و صفحات 2، 3، 4 و … میاد ما الان میخواییم فقط صفحه 1 ایندکس بشه و صفحه بندی ها ایندکس نشن

ممنون از سایت و پشتیبانی و پاسخدهی خوبتون